KURZMELDUNG

Denkt diese KI wie ein Mensch?

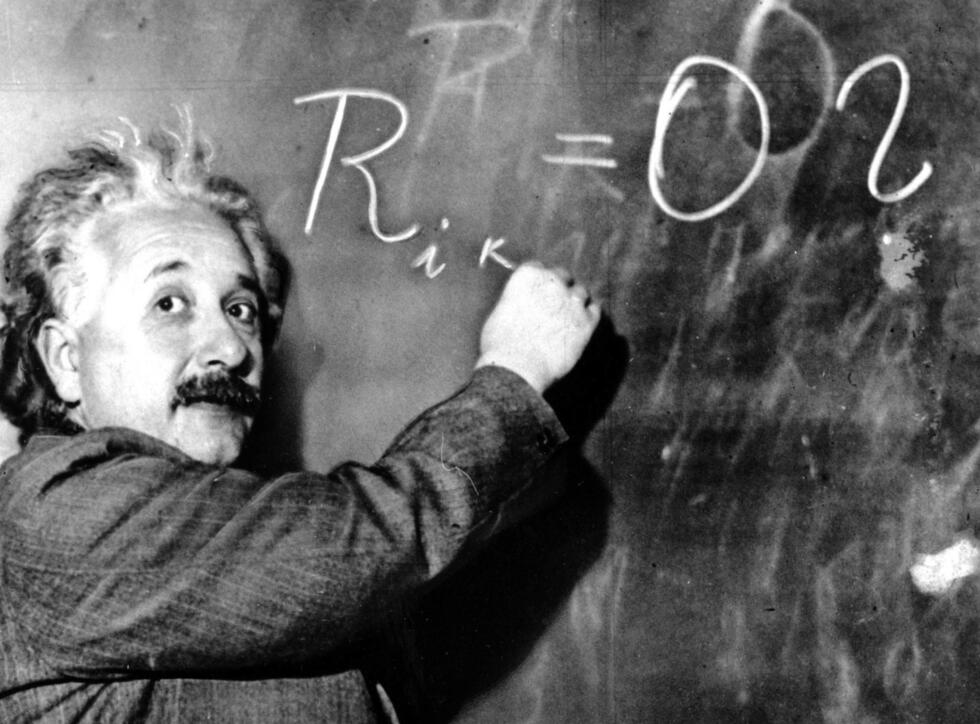

Forschende des MIT haben eine Methode entwickelt, die dem Benutzer hilft, das Denken eines maschinellen Lernmodells zu verstehen und es mit dem Denken eines Menschen zu vergleichen.

Beim maschinellen Lernen ist es oft genauso wichtig zu verstehen, warum ein Modell bestimmte Entscheidungen trifft, wie die Frage, ob diese Entscheidungen richtig sind. So könnte ein maschinelles Lernmodell beispielsweise korrekt vorhersagen, dass eine Hautläsion krebsartig ist, aber es könnte dies auch anhand eines nicht verwandten Flecks auf einem klinischen Foto tun.

Es gibt zwar Tools, die Experten dabei helfen, die Argumentation eines Modells zu verstehen, aber diese Methoden bieten oft nur Einblicke in jeweils eine Entscheidung – und jede muss manuell bewertet werden. Modelle werden jedoch in der Regel anhand von Millionen von Dateneingaben trainiert, so dass es für einen Menschen fast unmöglich ist, genügend Entscheidungen auszuwerten, um Muster zu erkennen.

Auffälliges Verhalten entdecken

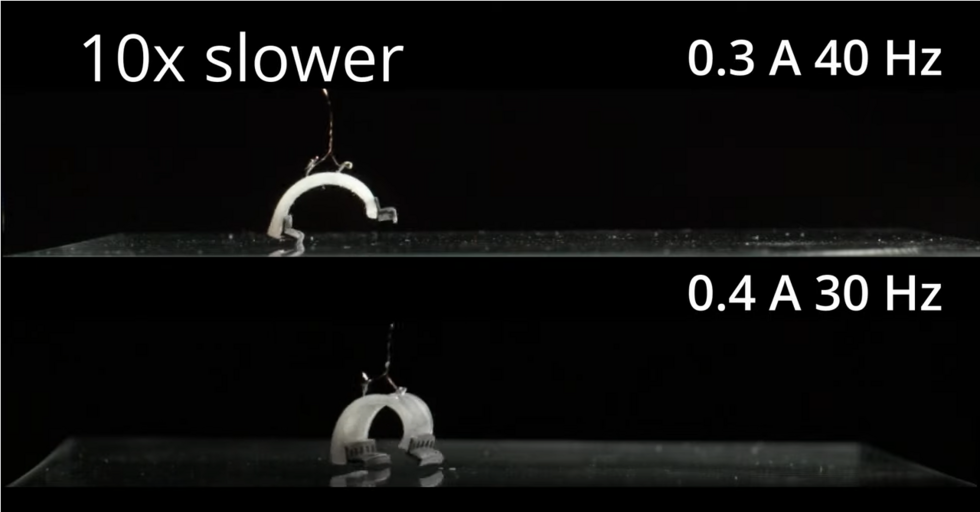

Forscher des MIT und von IBM Research haben nun eine Methode entwickelt, die es einem Benutzer ermöglicht, diese einzelnen Erklärungen zu aggregieren, zu sortieren und zu bewerten, um das Verhalten eines maschinellen Lernmodells schnell zu analysieren. Ihre Technik «Shared Interest» beinhaltet quantifizierbare Metriken, die vergleichen, wie gut die Argumentation eines Modells mit der eines Menschen übereinstimmt. Damit könnte ein Benutzer auf einfache Weise auffällige Trends in der Entscheidungsfindung eines Modells aufdecken – zum Beispiel, wenn das Modell häufig durch ablenkende, irrelevante Merkmale wie Hintergrundobjekte in Fotos verwirrt wird.