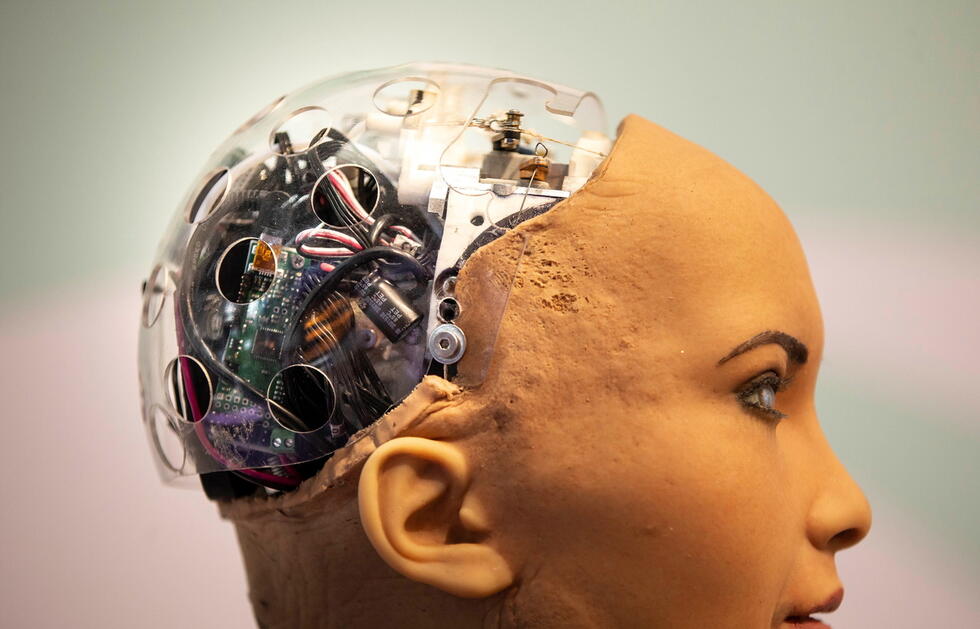

KI mit EQ

Sie werden immer besser: Roboter, die menschliche Gefühle erkennen oder simulieren. Wozu sind sie gut, und wie funktionieren die Systeme? Ein Blick in zwei Forschungslabore.

Maschinen, die sich wie Menschen verhalten, eifersüchtig, beleidigt oder fröhlich sind – in Hollywood gibt es sie längst. In Wirklichkeit nimmt die Entwicklung emotionaler Roboter erst richtig Fahrt auf. «Systeme mit Emotionalität und Persönlichkeit auszustatten, ist eines der grossen aktuellen Forschungsthemen im Bereich Künstliche Intelligenz», sagt Björn Schuller, Informatikprofessor an der Universität Augsburg und am Imperial College London.

Wenn heute von «emotionaler KI» die Rede ist, handelt es sich allerdings meist um Emotionserkennungssysteme; um empathische KI sozusagen. «Darauf liegt momentan der Hauptfokus», erklärt Björn Schuller. Der Grund: Der Nutzen von Emotionserkennung ist sehr breit. Schuller: «Solche Algorithmen verbessern die Kommunikation zwischen Mensch und Maschine grundlegend.» Sie verstehen zum Beispiel auch Zynismus oder Ironie.

In der Marktforschung schon im Einsatz

Kein Wunder also, dass sich diverse Branchen für Emotionserkennung interessieren und die Systeme mehr und mehr in den Bereich robuster Anwendbarkeit kommen. Bereits im Einsatz ist die Technologie in der Marktforschung. Dort werten emotional kompetente Algorithmen Call-Center-Telefonate aus oder beobachten Testpersonen direkt beim Anschauen von TV-Spots. Das Stichwort: Implicit Tagging.

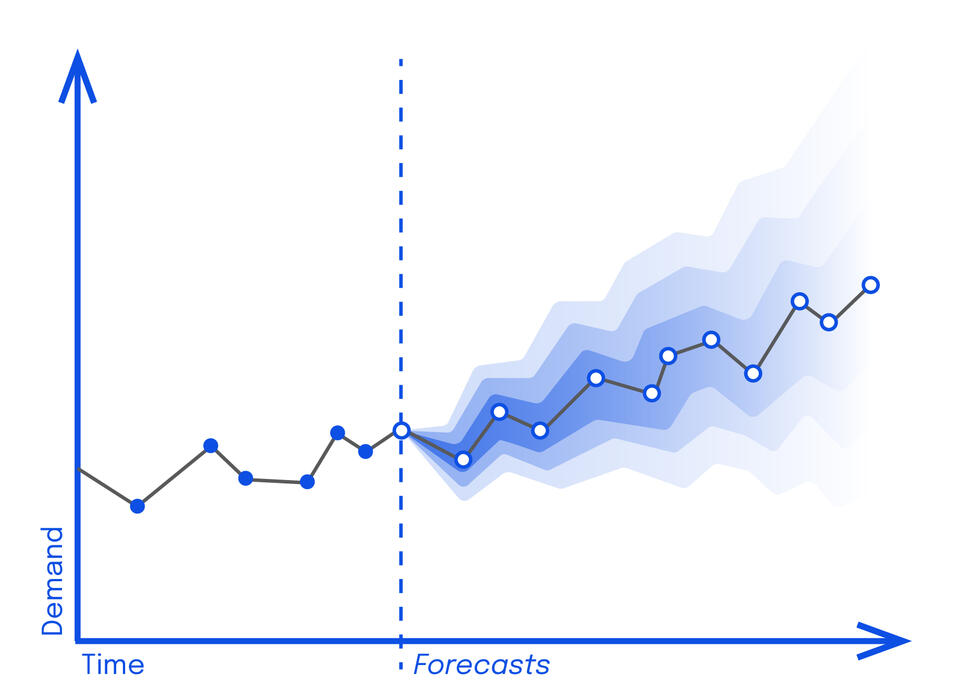

Weitere Anwendungsgebiete emotionaler KI sind Sicherheit oder Bildung: Die Systeme sollen künftig Aggressionen im öffentlichen Raum erkennen sowie Müdigkeit beim Autofahren oder Überforderung und Langeweile im Klassenraum. Und auch in unsere persönlichen Devices findet die Technologie zunehmend Eingang. Das US-Marktforschungsunternehmen Gartner rechnet damit, dass Ende 2022 zehn Prozent der Handys, PCs und Tablets mit emotionaler KI ausgestattet sein werden; um uns noch besser zu verstehen und uns das Leben zu erleichtern.

«Hierfür haben wir Spiele entwickelt, in denen die Kinder verschiedene Gefühle zeigen sollen und von einem Roboter dafür Punkte erhalten.»

Autismustherapie und Depressionserkennung

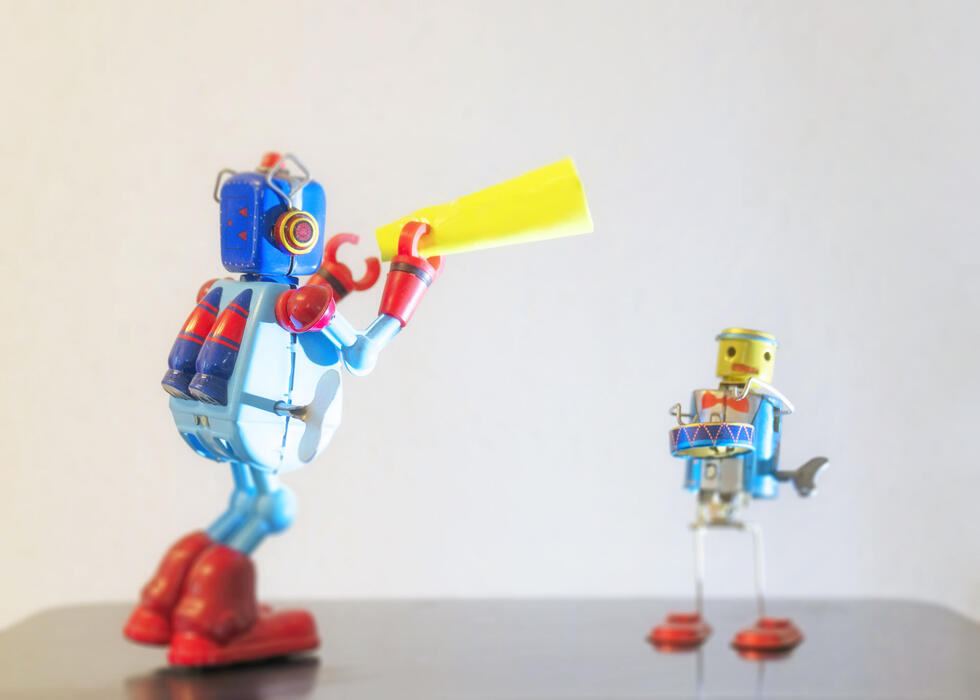

Das Leben von Menschen verbessern will Björn Schuller. An der Universität Augsburg arbeitet der Professor für Embedded Intelligence for Health Care and Wellbeing an emotional kompetenten Systemen für die Medizin. Zum Beispiel für die Autismustherapie. KI hilft dort Betroffenen, ihre Mitmenschen zu verstehen. «Etwa in Form einer Smartwatch, die vibriert, wenn das Gegenüber ironisch wird», macht Schuller ein Beispiel. Andere Systeme unterstützen autistische Kinder dabei, ihre Emotionen auszudrücken. «Hierfür haben wir Spiele entwickelt, in denen die Kinder verschiedene Gefühle zeigen sollen und von einem Roboter dafür Punkte erhalten.»

Natürlich: Feedback geben könnte auch ein Mensch. «Autistische Personen haben aber meist eine hohe technische Affinität und mögen den Umgang mit Robotern», erklärt Schuller. Und noch eine weitere Patientengruppe schätzt ein künstliches Gegenüber: Menschen, die an Depression erkrankt sind. Schuller: «Die Erkrankten öffnen sich einer KI gegenüber oft viel eher als einer Psychiaterin oder einem Psychiater. Sie fühlen sich unbefangener.» Depressionserkennung ist deshalb der andere Bereich, in dem der KI-Spezialist hauptsächlich tätig ist.

Emotionserkennung: Diese Arten gibt es

Maschinen nehmen menschliche Emotionen auf verschiedene Weisen wahr. Das sind die wichtigsten Methoden:

Maschinelles Sehen – Algorithmen erkennen Emotionen auf visueller Ebene. Sie interpretieren kleinste Gesichtsausdrücke – Micro Expressions –, Körperbewegungen und die Körperhaltung.

Sprachanalyse – Die Erkennung läuft über die Akustik: Die Systeme analysieren Ton, Tempo, Stärke oder Modulation der Stimme (zum Beispiel bei den Projekten an der Universität Augsburg). Oder die Emotionserkennung funktioniert linguistisch: über geschriebenen oder gesprochenen Inhalt.

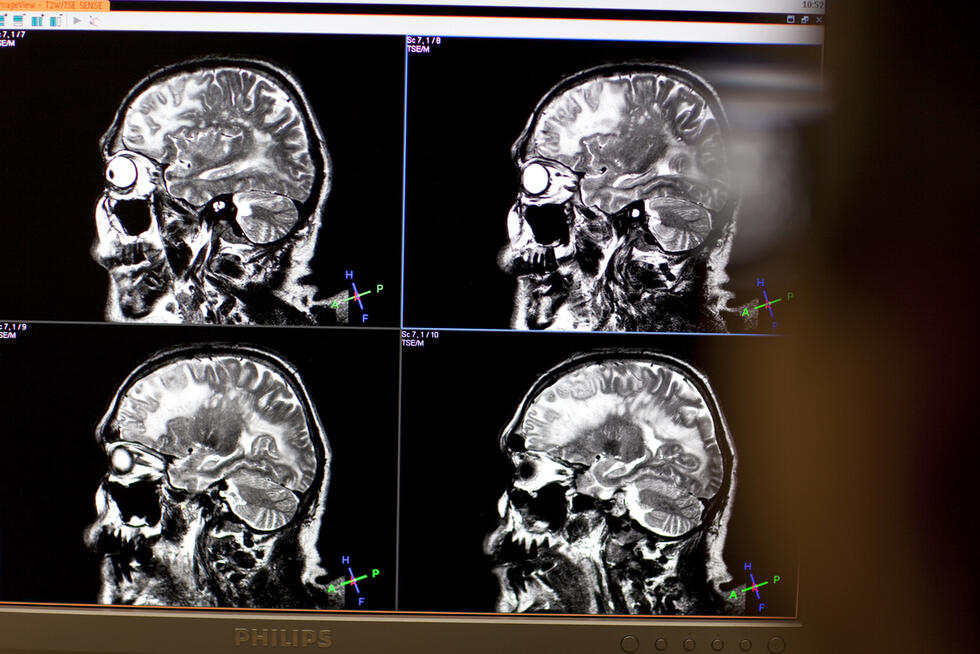

Physiologische Auswertung – Sensoren messen Puls, Körpertemperatur oder Hautleitwert und leiten daraus Emotionen ab. Bei Computer Interfaces geschieht dies direkt aus den Gehirnströmen.

So unterschiedlich wie die Erkennungsarten sind die Methoden, mit denen die Algorithmen Emotionen lernen: Neben Supervised, Unsupervised und Reinforcement Learning kommt immer häufiger auch Self Supervised Learning zum Einsatz. «Das ist gerade der letzte Schrei», so Informatikprofessor Björn Schuller. «Dabei lernen die Systeme mittels neuronaler Netze oft erst eine relativ einfache verwandte Aufgabe. Die Erkenntnisse daraus können sie dann gebrauchen, um nachgelagerte, schwierigere Aufgaben zu lösen.»

Ein Roboter mit eigenen Gefühlen

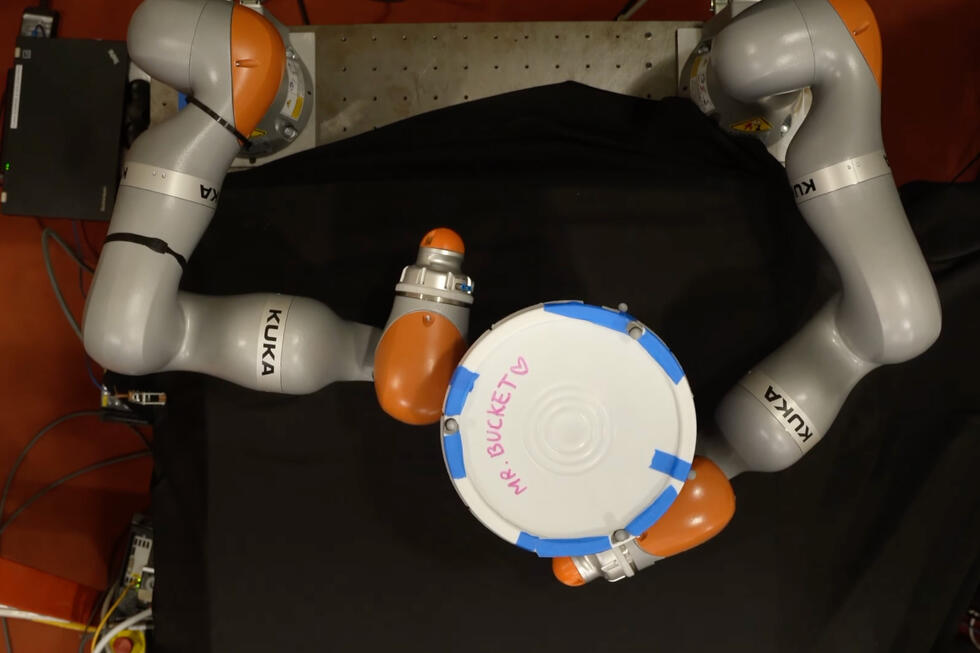

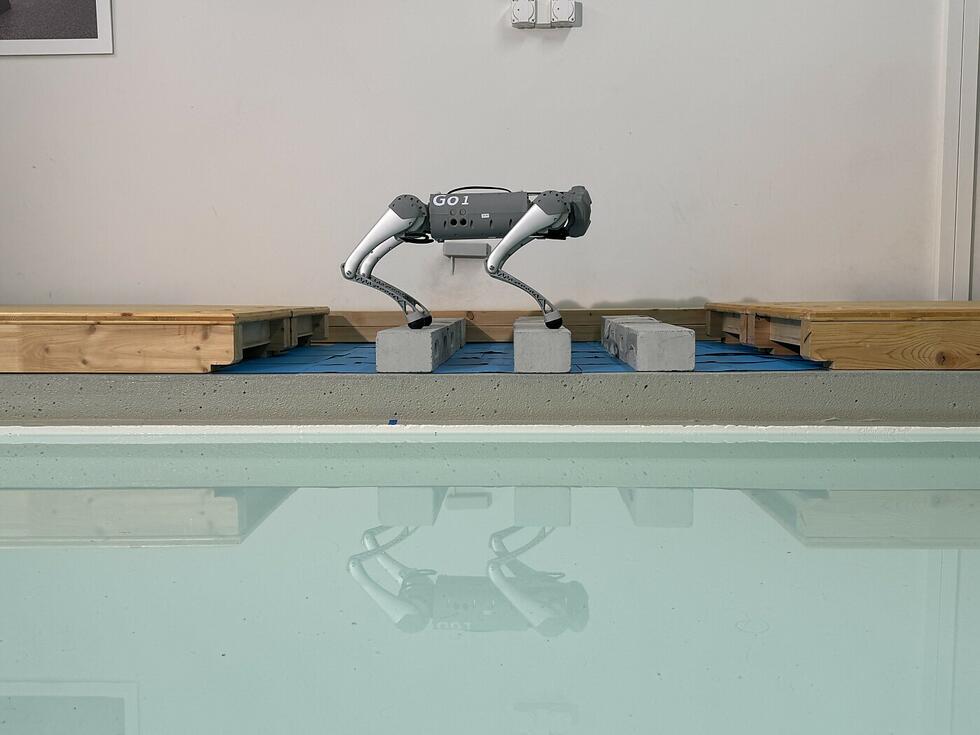

Ortswechsel: 300 Kilometer südwestlich von Augsburg, am neuen Zentrum für KI-Forschung an der ETH Zürich. Hier geht Benjamin Grewe einen Schritt weiter. Der assoziierte Professor für Neuroinformatik entwickelt KIs, die selber eine Art Gefühle haben. Denn: «Systeme, die nicht nur kognitiv, sondern auch emotional intelligent sind, können komplexe Aufgaben besser lösen», erklärt der Neuroinformatiker. Eine seiner KIs ist zum Beispiel in der Lage, Angst zu «empfinden». Später könnte damit etwa ein OP-Roboter gebaut werden. «Dieser wird dann vorsichtiger arbeiten und sicherer sein als bisherige Systeme.» Grewe sieht solche Anwendungen denn auch überall dort, wo Roboter Verletzungsgefahr mit sich bringen. «In der Medizin, aber auch in der Industrie, wo Mensch und Roboter vermehrt zusammenarbeiten.»

Das Roboter-Fear-System des ETH-Professors ist vom menschlichen Angstsystem inspiriert. Dieses ist leistungsfähiger als bei anderen Spezies. Einerseits funktioniert es über die Amygdala, das emotionale Zentrum vieler Lebewesen. «Beim Menschen kommt andererseits ein riesiger Neocortex hinzu, über den gefährliche Situationen eingeordnet werden können», so Grewe. «Sehen wir im Zoo zum Beispiel einen Löwen, rennen wir nicht weg – dank diesem Teil unseres Gehirns.»

«KI ist schlecht im Generalisieren»

Um diese beiden künstlichen Gehirnareale zu trainieren, verwendet Grewe Deep Q-Learning, eine Sparte des Reinforcement Learnings. Der Vorteil: Der Wissenschaftler braucht dazu nicht tausende Bilder, sondern kann die KI in der Simulation mit einem Skalpell ausrüsten und durch Trial und Error herausfinden lassen, welche Aktionen erfolgreich sind und welche nicht. Für gute Bewegungen gibt es eine positive Belohnung, für schlechte – zum Beispiel eine Gefässverletzung – eine negative.

Bis das Roboter-Fear-System zum Einsatz kommt, wird es allerdings noch fünf bis zehn Jahre dauern. Insbesondere zwei Probleme bereiten Benjamin Grewe Kopfzerbrechen: «KI ist noch ziemlich schwach im Generalisieren», erklärt er. «Sich von der Simulation an die Realität anzupassen oder von einem Patienten zum anderen, fällt ihr schwer.» Die zweite Herausforderung: Algorithmen sind vergesslich. «Noch gelingt es schlecht, KI auf bestehendem Wissen aufbauen zu lassen. Ich kann sie auf ein neues Problem ausrichten, dann geht aber alles verloren, was sie zuvor gelernt hat.» Dies ist jedoch eine generelle Herausforderung und gilt nicht nur für emotionale KI.

Simulierte Gefühle

Um Missverständnissen vorzubeugen: Keine KI der Welt hat aktuell echte Gefühle oder Empathie. «Es handelt sich immer um Simulation», stellt Neuroinformatiker Benjamin Grewe klar. Für richtige Gefühle bräuchte die KI ein Bewusstsein. «Und da sind wir noch lange nicht.»

Vorsicht, Manipulation

Beim Thema Emotionserkennung sind die Herausforderungen spezifischer. «Emotionen sind nicht eindeutig. Machine-Learning-Systeme tun sich deshalb schwer damit», benennt Experte Björn Schuller einen zentralen Knackpunkt. Menschen sind verschieden und drücken ihre Gefühle auch unterschiedlich aus. Und selbst, wenn sie es auf die gleiche Art tun: Oft liegen die Emotionsausdrücke sehr nahe beieinander, speziell visuell. «Frustration zum Beispiel beinhaltet meist ein kurzes Lächeln, das natürlich nichts mit Freude zu tun hat», so Schuller. Die Forschung kommt der Lösung jedoch zunehmend auf die Spur. «Moderne visuelle Emotionserkennung geht gar nicht mehr den Umweg über die Zwischenebene – das Lächeln –, sondern lernt zum Beispiel direkt ‘Frust’ und ‘Freude’.»

«Anbieter könnten emotional schwache Momente ausnutzen, um die Leute zum Kauf teurer Produkte zu verleiten.»

Zwar werden die Anwendungen immer besser. Machen sie jedoch Fehler, hat das womöglich heftige Konsequenzen. Damit beschäftigt sich Technikfolgenabschätzer Armin Grunwald intensiv. «Weil Emotionserkennung eben nicht immer zuverlässig funktioniert, ist es zum Beispiel problematisch, sie in der Strafverfolgung einzusetzen», so der Technikphilosoph. «Aus gutem Grund sind auch KI-basierte Lügendetektoren weltweit vor Gericht verboten.» Doch Zuverlässigkeit ist nicht das einzige Problem emotionaler KI: hinzu kommt Missbrauchsgefahr. «Anbieter könnten emotional schwache Momente ausnutzen, um die Leute zum Kauf teurer Produkte zu verleiten», macht Grunwald ein Beispiel.

Lesen Sie hier das Interview mit Armin Grunwald: Technik-Risiken rechtzeitig erkennen

An der Universität Augsburg führt die Missbrauchsgefahr emotionaler KI zu einer skurrilen Situation: Björn Schuller entwickelt dort nicht nur Systeme, die menschliche Emotionen erkennen. «Gleichzeitig arbeiten wir an technischen Lösungen, die den Menschen helfen, ihre Gefühle vor diesen Systemen zu verbergen.» Hollywood lässt grüssen.

Text:

Illustration: Reza Bassiri