KURZMELDUNG

Die Welt ist uneins über ethische Künstliche Intelligenz

Künstliche Intelligenz macht riesige Fortschritte. Bestenfalls sollte ihr Einsatz niemandem schaden. Nur wie lässt sich das bewerkstelligen? Die Antworten von Staaten, Unternehmen und Organisation fallen sehr unterschiedlich aus, wie Zürcher Forschende zeigen.

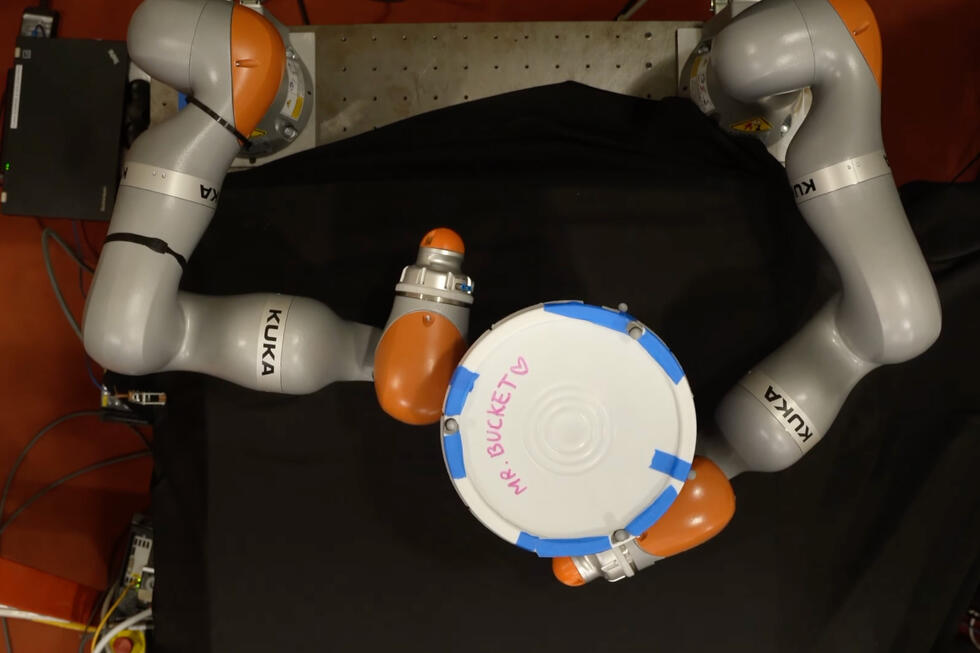

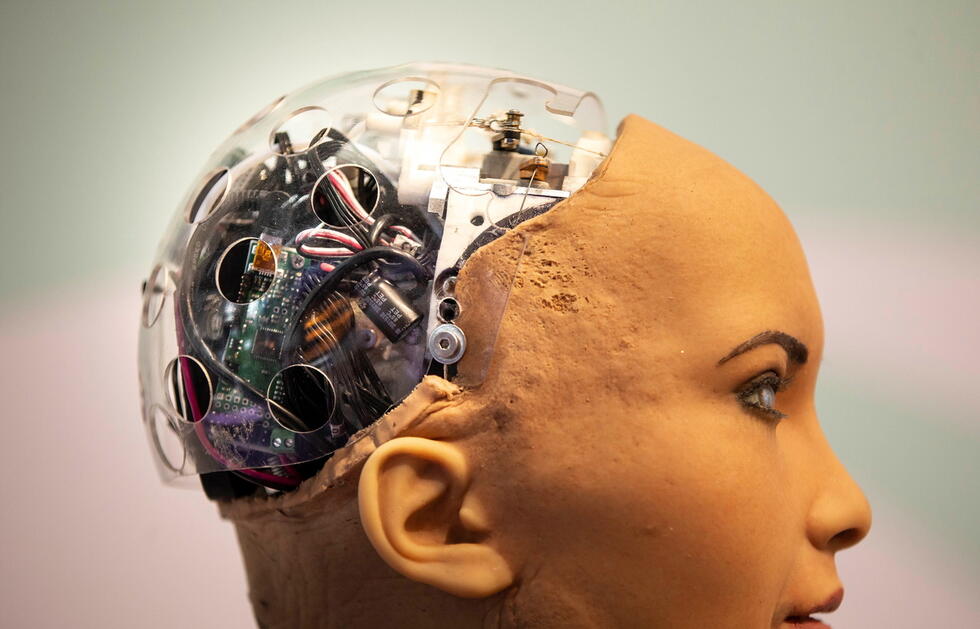

Künstliche Intelligenz (KI) weckt viele Ängste: dass lernende Algorithmen und intelligente Automatisierungen Menschen den Job kosten, dass KI zum Schaden der Bevölkerung eingesetzt werden oder durch Erlernen menschlicher Vorurteile oder unausgewogene Datensätze als Trainingsbasis bestimmte Gruppen diskriminieren könnte.

In Reaktion auf solche Ängste haben Staaten, Organisationen und Privatwirtschaft ethische Leitlinien entwickelt. Die Vorstellungen darüber, wie ein ethisch verantwortlicher Umgang mit KI aussehen sollte, gehen dabei teils weit auseinander, wie Forschende um Effy Vayena von der ETH Zürich berichten.

Das Forschungsteam hat 84 Dokumente gesammelt, die ethische Prinzipien und Leitlinien für KI festlegen. Sie reichen von Leitlinien von Unternehmen, die AI entwickeln oder einsetzen, über Berichte und Diskussionspapiere aus Expertengremien und Hochschulen bis zu Dokumenten von Regierungsorganen und internationalen Organisationen.

Kein einziges allgegenwärtiges Prinzip

«Diese ethischen Leitlinien zu KI sind in den letzten Jahren wie Pilze aus dem Boden geschossen», sagte Studienautorin Anna Jobin von der ETH Zürich im Gespräch mit der Nachrichtenagentur Keystone-SDA. «Deshalb wollten wir einen Überblick schaffen, woher diese Leitlinien stammen, welche ethischen Prinzipien genannt und wie stark sie gewichtet werden.»

Kein einziges ethisches Grundprinzip fand sich in allen Dokumenten, wie die Forschenden im Fachblatt «Nature Machine Intelligence» schreiben. Insgesamt konnten sie elf Prinzipien identifizieren, die aber sehr unterschiedlich häufig vorkamen. Fünf Eckpunkte kristallisierten sich heraus, die in mehr als der Hälfte der Leitlinien erwähnt wurden: Transparenz, Gerechtigkeit und Fairness, das Verhindern von Schaden, Verantwortung und Datenschutz. Allerdings fiel teils sehr unterschiedlich aus, was genau mit diesen Prinzipien gemeint ist und wie sie zu erreichen sind.

Transparenz war dabei das am häufigsten genannte Grundprinzip und tauchte in 73 von 84 Dokumenten auf. Das Schlagwort umfasst dabei Bemühungen, die Technologie hinter KI und ihre Verwendung verständlicher zu kommunizieren, oder auch die Art des Einsatzes und der Nutzung von Daten, den Quellcode, Limiten der Technologie oder auch Haftbarkeit offenzulegen.

Insbesondere die verständliche Kommunikation und dadurch auch die Überprüfbarkeit durch externe Kontrollinstitutionen («Audits») werde in den Dokumenten hervorgehoben. Das Hauptziel von Transparenz beim Einsatz von KI ist dabei das Vorbeugen von Missbrauch oder unerwünschten Nebenwirkungen der Technologie. Damit reicht dieses Grundprinzip auch übergreifend in die anderen vier Eckpunkte, beispielsweise um Schlagseite und Diskriminierung in von KI gefällten Entscheidungen zu verhindern.

Voller Widersprüche

«Erstaunlich ist, wie widersprüchlich die Dokumente in sich selbst teilweise sind», sagte Jobin. Beispielsweise sei ein oft genanntes Ziel, Diskriminierung zu verhindern, indem man möglichst noch grössere und dadurch ausgewogenere Datensätze ansammle. «Im gleichen Dokument findet man plötzlich das ethische Prinzip des Datenschutzes und dass Nutzer die Kontrolle über ihre Daten haben sollten. Das ist nur schwer mit dem Sammeln von noch grösseren Datenmengen zu vereinbaren.»

Während Transparenz sehr im Vordergrund der ethischen Leitlinien steht, werden andere Prinzipien eher selten erwähnt, wie Vertrauen, Solidarität oder auch Nachhaltigkeit. «Man kann sich jetzt fragen, ob das gerechtfertigt ist. Kann KI wirklich ethisch sein, wenn sie nicht das Prinzip der Nachhaltigkeit erfüllt?», so Jobin. «Dank dieses Überblicks wissen wir nun, wo wir künftig noch grösseren Fokus setzen müssen.»

Insgesamt stellten die Forschenden fest, dass sich die Dokumente aus Privatsektor und öffentlichen Institutionen zahlenmässig die Waage hielten, sich also beide Bereiche mit einem verantwortungsvollen Umgang mit KI auseinandersetzen.

Debatte geprägt von reichen Ländern

Allerdings stellte sich heraus, dass bestimmte Weltregionen bisher offenbar kaum teilnehmen an der Debatte zur Ethik von KI. Unterrepräsentiert sind demnach insbesondere Afrika, Süd- und Mittelamerika, sowie Zentralasien.

Dies zeige ein globales Ungleichgewicht: Industriell weiter entwickelte Länder prägten die Diskussion, was dazu führen könnte, dass lokales Wissen, kultureller Pluralismus und globale Fairness in der Debatte zu kurz kämen. «Wenn wir den Anspruch haben, dass KI weltumgreifend wirken soll, sollte auch die ganze Welt mitreden», sagte Jobin.

Anstatt immer neue Richtlinien zu erstellen, sollte sich die Debatte vielleicht mehr um die Prozesse drehen, wie man zu ethischen Grundprinzipien zu KI kommt und wie diese umgesetzt werden sollten, erklärte die Forscherin. «Was unsere Auswertung deutlich gezeigt hat, ist, dass der Teufel im Detail steckt.» Eine einfache Antwort auf die Frage nach ethisch verantwortlichem Einsatz von KI gebe es nicht. «Aber Ethik ist eben ein Prozess, keine Checkliste.»